자율주행

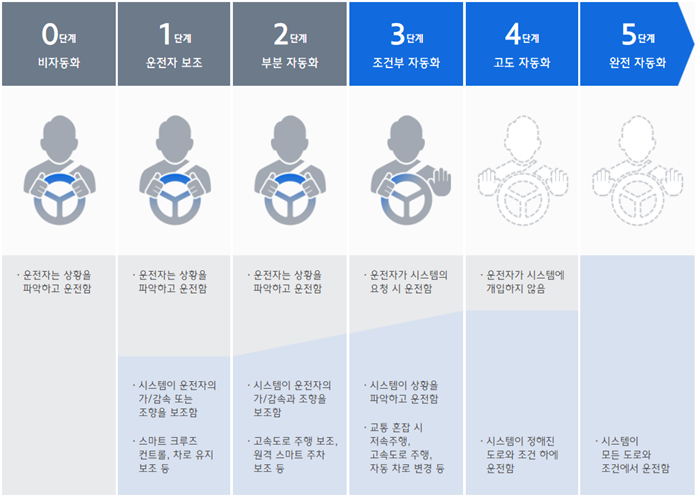

1925년 처음 원격조종차가 등장한 이후 자율주행에 대한 연구가 계속되었습니다. 1980년대 들어 유명 자동차 기업인 벤츠, BMW, 아우디 등이 무인 자동차 프로젝트에 참여하면서 연구는 더욱 박차를 가했다. 2000년대 들어서는 우리가 잘 알고 있는 테슬라, 구글 등이 자율주행 기술을 개발 중입니다.미국자동차기술학회(SAE)는 자율주행 발달 수준을 6개 단계로 나눴는데 곧 완전 자율주행인 5단계에 이를 것으로 예상됩니다. 먼저 자율주행 기술 발달 수준에 대해 알아보겠습니다.

자율성 수준

레벨 0의 레벨은 수동 제어 차량에서 자율성이 전혀 없음을 나타냅니다. 물론 차량 시스템에 도로 주행 시 필요한 몇 가지 보조 기능이 운전자가 차를 운전하는 데 도움이 됩니다. 그러나 비상 제동 시스템이나 경로 제어처럼 차량을 ‘주행’하지 않는 기능은 자율성을 인정받지 못하므로 레벨 0 시스템으로 간주합니다. 오늘날 도로를 달리는 대부분의 차량의 자율성은 레벨 0입니다.

레벨 1 최저 수준의 자율주행 단계인 레벨 1은 운전자를 지원하는 자동화 시스템을 갖추고 있습니다. 대표적인 예로 뒷차와의 안전 간격을 유지할 수 있도록 돕는 기능은 레벨 1의 자율성을 보여줍니다. 이러한 시스템은 다양하지만 일반적으로 LiDAR, 레이더 또는 카메라 조합을 통해 자동으로 가속 또는 브레이크를 작동시켜 차량이 앞뒤 차량과 안전한 거리를 유지하도록 합니다. 최근 출시되고 있는 많은 신형 자동차 모델들은 이 기능을 탑재하고 있어 레벨1 자율주행차라고 할 수 있습니다.

레벨 2 레벨 2 단계는 첨단운전자보조시스템(ADAS, Advanced Driver Assistance System) 사용 여부를 통해 알 수 있습니다. ADAS는 스티어링 장치(Steering)와 차량의 가속 또는 감속 모두를 제어할 수 있습니다. ADAS는 조기 경보 및 자동화 시스템을 통해 운전자의 위험 대처 능력을 향상시킵니다. ADAS는 고성능 센서, 카메라, LiDAR을 활용하여 360도 3D 이미지 및 실시간 데이터를 제공합니다. ADAS에는 안티 브레이크, 전방 충돌 경고, 차선이탈 경고, 트랙션 컨트롤 등의 다른 기능도 있습니다. 현재 레벨 2의 예로는 테슬라(테슬라)의 Autopilot(오토파일럿)과 Cadillac(캐딜락)의 SuperCruise System(슈퍼크루즈 시스템) 등이 있습니다.

테슬라 Enhanced Autopilot 레벨 3 주변 환경을 감지할 수 있으며 획득한 정보를 통해 스스로 결정을 내릴 수 있는 차량이 레벨 3단계 자율주행차입니다. 이러한 기능을 가진 차량이라도 작업을 수행할 수 없는 경우에는 여전히 사람의 개입이 필요합니다. 아우디(아우디) A8L은 레벨3 라이다, 센서 등을 결합한 트래픽잼필롯이라는 자율기술을 선보일 예정이었지만 글로벌 규제당국의 승인을 받지 못해 레벨3를 포기해야 했던 바 있습니다.

레벨 4와 레벨 4의 주요 차이점은 문제가 발생하거나 시스템 장애가 발생할 경우 레벨 4 차량은 스스로 개입해 문제를 해결할 수 있다는 것입니다. 따라서 이러한 레벨 4 차량은 대부분의 상황에서 사람의 개입이 필요하지 않습니다. 그래도 운전자가 수동으로 차를 조종할 수 있는 옵션이 있습니다. 앞으로 레벨 4 차량은 택시 및 대중교통 용도로 활용될 전망입니다.

레벨 5 레벨 5 차량은 완전 자율주행이 가능하며 운전자가 개입할 필요는 없습니다. 이러한 차량에는 스티어링 휠이나 페달과 같은 일반적인 차량의 구성 요소가 없습니다. 레벨 5 차량에 대해서는 몇 가지 테스트가 있습니다만, 아직 일반인이 이용할 수 있는 테스트는 없습니다.

최근 많은 자동차 업체들이 2018년부터 2025년 사이에 레벨5 차량을 사용할 수 있다는 주장을 철회하면서 레벨5 자율주행이 언제쯤 완성될지 불투명해졌습니다. 현재 출시된 차량의 자율주행 기술은 레벨 2 레벨로 레벨 3부터는 차량 주행의 주체가 차량이 되기 때문에 사고의 책임도 차량이나 제조사가 됩니다. 그래서 많은 제조사들이 아직 레벨 3 단계를 출시하는 것을 꺼리고 있습니다. 결국 자율주행을 승인받은 차량은 극소수여서 아직 혁신의 여지가 있어 보여 5단계 자동화가 이뤄지기까지는 10년이 걸릴 것으로 보입니다.

자율주행차의 센서 융합

센서 융합

센서 융합은 여러 센서의 Raw 데이터를 기반으로 추정된 데이터를 출력해야 하는 다양한 시스템에서 활용됩니다. 센서 융합은 여러 센서 입력을 결합하여 개별 센서의 입력보다 정확하게 통합된 하나의 결과를 생성하는 기능입니다. 센서 융합의 대표적인 예로 카르만 필터가 있습니다.

카르만 필터는 시간의 경과에 따른 일련의 관측된 측정값을 활용하여 자연스럽게 발생하는 통계적 노이즈 및 기타 부정확성을 필터링하여 센서만의 데이터보다 정확한 합산 추정치를 생성합니다.

자율주행에서의 센서 융합

ADAS(Advanced Driver Assistance System) 현재 ADAS를 탑재한 많은 차량은 레이더, 광학 카메라, LiDAR 또는 초음파와 같은 다양한 센서의 정보를 활용합니다. 센서 융합은 이러한 센서의 정보를 결합하여 주변 환경을 보다 명확하게 파악할 수 있도록 합니다. ADAS에서 센서 융합의 대표적인 예는 전방 카메라와 레이더 사이의 정보 융합입니다. 단독으로 사용할 경우 두 센서가 주변 환경을 완전히 검출할 수 없습니다. 카메라는 비, 안개, 일광 반사 등의 조건에서 문제가 있지만 색 인식으로는 신뢰할 수 있는 소스가 됩니다. 레이더는 물체 거리를 측정하는 데 도움이 되지만 도로 표지판과 같은 특징적인 것을 인식하기에는 좋지 않습니다. 카메라와 레이더 간 센서 융합은 Adaptive Cruise Control(ACC) 및 Automous Emergency Braking(AEB)과 같이 신형 자동차 모델에서 볼 수 있는 ADAS의 예를 통해 자세히 확인할 수 있습니다.

ADAS (Advanced Driver Assistance System)

자율주행차를 앞서 언급했듯이 자율주행차 시스템에서 센서 융합의 가장 큰 장점은 다양한 센서의 융합된 데이터가 개별 센서의 단점을 극복할 수 있다는 것입니다. 결과적으로, 이것은 각각의 단점을 보완하는 동시에 시스템의 전체적인 성능과 신뢰성을 향상시킵니다. 자율주행차 스스로 경로를 정할 때 센서 융합의 중요성이 가장 드러납니다. 이 경우 각각의 센서에 의해 읽힌 값이 통합되어 차량의 상태를 정밀하게 분석하고 주변 물체의 궤적을 예측합니다. 융합된 센서의 노이즈 분산은 개별 센서에 의해 판독된 값의 분산보다 작기 때문에 차량의 환경을 보다 정밀하게 인식할 수 있습니다.

Autonomous Vehicle

자율주행차에 대한 Inertial Labs 솔루션

Inertial Labs_INS-DInertial Labs의 INS-D

미국 Inertial Labs의 INS-D는 자이로스코프(Gyroscope), 가속도계(Accelerometer), 플럭스게이트 자력계(Fluxgate Magnetometer), 듀얼 안테나 GNSS 수신기(Dual Antenna GNSS Reiver) 및 기압계(Barometer) 데이터를 이용하는 관성항법시스템(INS)입니다. 측정 물체의 정확한 위치(Position), 속도(Velocity), 헤딩(Heading), 피치(Pitch) 및 롤(Roll)을 제공하기 위해 하나의 보드에 센서를 구성하고 융합 필터로 이러한 데이터를 입력시킵니다. INS-D는 LiDAR, 광학 카메라 또는 레이더(Radar) 보조 데이터와 융합하여 사물인식 또는 SLAM(Simultaneous Localization and Mapping) 알고리즘에 필요한 데이터를 제공할 수 있습니다. 예를 들어 INS-D는 LiDAR 및 광학 카메라 데이터와 융합하여 수 센티미터 이내에 정확한 차량 항법용 지리 정보 및 타임스탬프 데이터를 생성할 수 있습니다. 지리 정보는 지리 좌표계와 관련된 데이터이기 때문에 이 데이터는 물리적 공간에서 정확한 위치 정보를 가지며, 이는 차량 주변의 지형을 매핑하는 데 매우 중요한 역할을 합니다. 또한 광학 카메라와 센서의 융합을 통해 이 주변의 지형 데이터에 색을 입힐 수 있습니다. 이는 카메라 이미지가 LiDAR의 지리 좌표 데이터 위에 투영되어 각 포인트가 실제 그 위치의 색상에 씌워지는 것을 의미합니다. 이는 특히 도로선과 같은 사물 감지 및 특징적인 부분 인식에 중요한 역할을 합니다.

실제 응용 사례

버지니아공대(Virginia Tech) Inertial Labs는 버지니아공대 기계공학부 Autonomous Systems and Intelligent Machines(ASIM) 연구소와 함께 커넥티드 자율주행차(CAV, Connected and Autonomous Vehicles)에 대한 연구를 진행하고 있습니다. 학생들은 하이브리드 세단을 자율주행차로 만들기 위해 INS-D를 다른 다양한 센서와 함께 사용합니다. ASIM 연구소는 동적 시스템과 지능 제어 관점에서 자율주행에 관한 연구를 수행할 목적으로 설립되었습니다. ASIM연구소는 센서융합기술, 통신기술, 첨단 알고리즘을 통해 자율 또는 반자율 로봇과 차량 등 지능형 기계를 개발해 오고 있습니다.

로보틱스 플러스 로보틱스 플러스는 정밀농업 분야에 적합한 무인 지상차량(UGV) 라인을 개발했습니다. 광학 보조 데이터와 융합된 관성 항법 시스템(INS)은 실시간 지리 좌표 데이터를 생성할 수 있습니다. 첨단 알고리즘에 이 데이터가 입력되면 UGV가 주변 환경을 인식할 수 있습니다. 과수원과 원예 작업을 기계화하려는 수요로 인해 이러한 UGV는 다양한 환경에서 다양한 용도로 적용되도록 지속적으로 개발되고 있습니다. 로보틱스 플러스는 노동력 부족, 작물의 지속가능성, 수분 부족 및 수확량 확보라는 점점 더 중요해지는 농업 과제를 해결하기 위해 만들어졌습니다. Inertical Labs는 Robotics Plus와 협력하여 재배 능력을 향상시키고 수확량 확보를 지속적으로 개선하고자 하는 목표를 달성하기 위해 함께 노력하고 있습니다.

Pliant Offshore Pliant Offshore는 3D 소프트웨어 기술과 융합한 해상 측정 및 제어 분야 전문 업체입니다. Inertial Labs는 Pliant Offshore와 협력하여 가혹한 환경을 견딜 수 있고 정밀한 결과를 낼 수 있는 정밀 제품을 개발하였습니다. Inertial Labs의 관성 기술은 Pliant Offshore의 무인선박(USV, Unmanned Surface Vehicle)에서 추적 및 모니터링용으로 이용된다. USV는 Multi-Beam Echo Sounder(MBES)와 융합된 Inertial Labs의 MRU(Motion Reference Unit) 센서를 사용하여 정확한 지리 좌표 데이터로 감시 및 모니터링을 수행할 수 있습니다. Initial Labs는 Plant Offshore와 지속적으로 협력하여 사용자의 시간효율, 비용효율, 안전성을 극대화하기 위해 제품을 개발하고 개선하고 있습니다.